Diversidad en IA: hombres y mujeres invisibles

En junio, estalló una crisis en el mundo de la inteligencia artificial.

La conversación en Twitter estalló después de que una nueva herramienta para crear imágenes realistas y de alta resolución de personas a partir de fotos pixeladas mostrara su prejuicio racial , convirtiendo una foto pixelada pero reconocible del expresidente Barack Obama en una foto de alta resolución de un hombre blanco .

Los investigadores pronto publicaron imágenes de otros famosos negros, asiáticos e indios, y otras personas de color, que se volvieron blancos.

diversidad en ia: los hombres y mujeres invisibles

La conversación se volvió intensa. Dos conocidos investigadores corporativos de IA, el científico jefe de IA de Facebook, Yann LeCun, y el codirector de ética de IA de Google, Timnit Gebru, expresaron puntos de vista muy divergentes sobre cómo interpretar el error de la herramienta. Se produjo un acalorado debate en línea de varios días, que dividió el campo en dos campos distintos: algunos argumentaron que el sesgo mostrado en los resultados provenía de datos incorrectos (es decir, incompletos) que se ingresaron en el algoritmo, mientras que otros argumentaron que provenían de datos incorrectos ( es decir, miope) decisiones sobre el algoritmo en sí, incluidos los datos a considerar.

Una nueva herramienta de inteligencia artificial convirtió una foto pixelada del coautor de esta columna, Charles Isbell, de una imagen de un hombre negro a una imagen de un hombre blanco.

diversidad en ia: los hombres y mujeres invisibles

El sesgo ha plagado el campo de la IA durante años, por lo que la transformación fotográfica de blanco a negro de esta herramienta de IA en particular no es completamente inesperada. Sin embargo, lo que el debate dejó en evidencia es que no todos los investigadores de IA han aceptado las preocupaciones sobre la diversidad. Este es un hecho que afectará fundamentalmente a cualquier organización que juegue en el espacio de la IA.

Es más, aquí hay una pregunta a la que muchas organizaciones deberían prestar atención: ¿Por qué no se le ocurrió a nadie probar el software en casos que involucran a personas de color en primer lugar?

diversidad en ia: los hombres y mujeres invisibles

Diríamos que este es un caso de invisibilidad. A veces hay gente de color presente y no nos ven. Otras veces nos falta, pero nuestra ausencia no se nota. Este último es el problema aquí.

Una crisis engendra otra

Parte del problema es que hay relativamente pocas personas negras y otras personas de color que trabajan en IA.

En algunas de las principales empresas de tecnología, las cifras son especialmente sombrías : los trabajadores negros representan solo el 2,5% de toda la fuerza laboral de Google y el 4% de Facebook y Microsoft.

Las comparaciones de género también son claras: a nivel mundial, solo el 22% de los profesionales de la IA son mujeres , mientras que el 78% son hombres. (Las matemáticas son simples pero vale la pena exponerlas explícitamente). Existe una escasez de diversidad en el profesorado también, lo cual es preocupante dado que las universidades son las principales organizaciones donde se capacita a los profesionales de la IA.

diversidad en ia: los hombres y mujeres invisibles

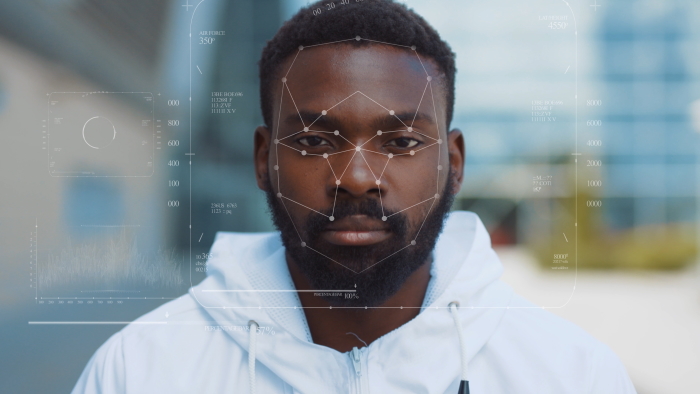

Teniendo en cuenta el papel cada vez más importante que desempeña la IA en los procesos comerciales de las organizaciones, en el desarrollo de sus productos y en los productos mismos, la falta de diversidad en la IA y la invisibilidad de las personas de color se convertirán en una cascada de crisis, con problemas acumulados uno sobre otro, si estos sesgos no se abordan pronto. Ya hemos visto empresas que retiran sus dólares de publicidad de Facebook debido a su mal manejo del discurso de odio. Hemos visto empresas emitir moratorias en la venta de software de reconocimiento facial , que durante mucho tiempo ha sido reconocido por tener prejuicios raciales y de género incorporados.

Francamente, estamos en un momento en que la crisis de la pandemia y la apresurada adaptación de la IA para rastrear la propagación de COVID-19 brindan una oportunidad única para instituir el cambio en el mundo de la IA. Esto incluye cambios en los problemas de prejuicio inherentes causados por la subrepresentación de profesionales negras y mujeres, así como de otros grupos tradicionalmente subrepresentados en el campo.

diversidad en ia: los hombres y mujeres invisibles

Abordar el problema de invisibilidad de la IA

Proponemos que para abordar los problemas generales de la subrepresentación en la IA, todos podemos aprender algunas lecciones del modelo de desarrollo específico utilizado dentro del campo de la IA. Es decir, cuando los investigadores desarrollan un nuevo producto de IA, mitigan el sesgo una vez que se dan cuenta de él y asumen la responsabilidad de solucionarlo. Los temas más importantes que estamos discutiendo se pueden abordar con la misma mentalidad.

Hay tres puntos clave de apalancamiento:

1. Reconozca que las diferencias importan. En el aprendizaje automático, no solo es suficiente introducir datos diversos en un sistema de aprendizaje. Más bien, un sistema de inteligencia artificial también debe diseñarse para que no ignore los datos solo porque parece ser anómalo en función de la pequeña cantidad de puntos de datos.

Así como las diferencias en los datos son importantes, las diferencias dentro de la fuerza laboral también son importantes. El enfoque de la inteligencia artificial para abarcar datos diversos es análogo al reconocimiento de que existe una diferencia entre igualdad y equidad en la fuerza laboral: la igualdad significa proporcionar a todos los mismos recursos dentro de un proceso establecido, pero la equidad exige prestar atención a lo que sucede a lo largo de un proceso, incluyendo examinar la equidad del proceso en sí. Las organizaciones deben prestar atención a la incorporación de diversas voces, no solo cuando están reclutando personas, sino también cuando están elaborando estrategias en torno a la retención y el desarrollo. Las empresas deben retener esas voces y no ignorarlas porque son pequeñas en número.

diversidad en ia: los hombres y mujeres invisibles

2. Reconozca que la diversidad en el liderazgo es importante. En la inteligencia artificial y el aprendizaje automático, los métodos de conjunto, es decir, los sistemas de aprendizaje que combinan diferentes tipos de funciones, cada una con sus propios sesgos diferentes, han sido reconocidos durante mucho tiempo por tener un mejor rendimiento que los métodos completamente homogéneos. Estos sistemas de aprendizaje son líderes en la optimización de los resultados de la IA y son diversos por diseño.

El paralelo para las organizaciones que quieren abordar la subrepresentación de voces negras y femeninas es que tener diversidad en el liderazgo también conduce a la diversidad en cómo se reconocen los problemas y cómo se desarrolla el talento. Por ejemplo, después de la eliminación de la segregación de las escuelas en los Estados Unidos que siguió al caso de la corte Brown v. Board of Education de 1954, los Estados Unidos vieron una caída significativa en la diversidad entre los maestros . Existe una línea directa entre esta caída en la diversidad entre los guardianes de la educación y la correspondiente caída en la recomendación de estudiantes negros para programas para superdotados y talentosos. Cuando se trata de quién es visto y quién no, importa dramáticamente quiénes son los líderes y los guardianes.

3. Reconozca que la responsabilidad es necesaria. En inteligencia artificial y aprendizaje automático, una máquina aprende mediante una función de pérdida , un método para evaluar qué tan bien un algoritmo de búsqueda específico modela los datos dados. Si las predicciones se desvían demasiado de los resultados reales, una función de pérdida castiga al sistema de aprendizaje en consecuencia, porque sin un incentivo objetivo y claro que le permita a un sistema saber cómo está funcionando, no hay forma de saber cómo está funcionando.

Esta es la esencia de la responsabilidad de la IA.

La responsabilidad es importante cuando las empresas pretenden estar trabajando para solucionar problemas de subrepresentación. Las empresas saben desde hace mucho tiempo que la diversidad étnica y de género afecta el resultado final. Informe tras informe muestra que las empresas que están rezagadas en cuanto a diversidad étnica y de género entre su fuerza laboral, equipos de gestión, ejecutivos y salas de juntas tienen menos probabilidades de lograr una rentabilidad superior al promedio . En nuestra mente, esto se correlaciona con un dicho muy conocido en la comunidad de inteligencia artificial y computación: “La basura entra, la basura sale”.

Dicho de manera más simple, si el liderazgo y la fuerza laboral de una organización no reflejan la diversa gama de clientes a los que sirve, eventualmente se considerará que sus resultados son deficientes. Debido a que los algoritmos de aprendizaje son parte de sistemas más grandes compuestos por otras tecnologías y las personas que los crean e implementan, el sesgo puede infiltrarse en cualquier parte del proceso. Si la diversidad dentro de la tubería de una organización es baja en algún momento, la organización se abre a sesgos, incluidos los que son lo suficientemente profundos y, potencialmente, lo suficientemente públicos como para dividir a los clientes y eventualmente llevar a la obsolescencia y al fracaso. Algunos clientes se quedarían, pero otros se irían.

Aunque las empresas afirman que han intentado abordar esta crisis de diversidad, la aguja apenas se ha movido . Desde 2014, cuando las grandes empresas de tecnología comenzaron a publicar informes anuales de diversidad, pocas han hecho mucho terreno en términos de diversidad étnica. Algunos han logrado pequeños avances en la diversidad de género.

Las empresas de tecnología se han centrado en problemas puntuales y soluciones puntuales. En otras palabras, han estado apagando incendios y no han abordado las causas fundamentales. Pero no se puede simplemente aplicar un vendaje a una herida que brota cuando es necesario un torniquete. Las organizaciones y aquellos que realmente desean liderar en esta área deben dejar de enfocarse en una sola área, un producto y una controversia. El problema real es generalizado y sistémico, y exige soluciones creativas y una verdadera responsabilidad.